These Three Red States Are the Best Hope in Schooling – neste artigo do New York Times, verifica-se que os estados republicanos, especialmente os do sul, mais pobres e mais conservadores, estão a ter mais sucesso educativo do que estados democratas, supostamente mais ricos e com políticas mais “progressistas”.

De 1990 a 2015, os resultados educacionais melhoraram no ensino básico e secundário americano (K12), mas a partir daí começaram a descer. Têm sido atribuídas as seguintes causas: redes sociais, ecrãs e baixa assunção de responsabilidades na educação (“accountability”).

Vários estados deixaram de dar tanta importância à avaliação externa (“testing and outcomes”), mas isso não aconteceu em sítios como Mississippi, Louisiana e Alabama. A lei de No Child Left Behind de 2002, iniciada com G. W. Bush (lembremo-nos de que ele estava a ler com crianças numa escola quando o vieram informar do 11/9), foi abandonada em 2015, no tempo de Barack Obama. Acho que isso se deve a posições ideológicas sobre educação que devem ser revistas.

Alguns diretores de escolas do Mississippi resumem o sucesso no seguinte “não aceitamos escusas”. Pode haver muitas explicações sociais para o insucesso, mas o que interessa é o que se faz perante essas situações.

Dá-se o exemplo dum aluno do 3.º ano que na verdade ainda se encontra no nível 1. É retirado da turma para um grupo de alunos que se concentra numa tarefa: aprender a ler.

Aqui vejo um problema bastante comum a Portugal: as turmas são feitas com critérios burocráticos (passou ou não de ano? e o que significa isso?) e não com base em critérios pedagógicos. Se a diversidade de níveis efetivos de desempenho for muito grande, o professor terá dificuldade em desenvolver as aprendizagens de todos. E o princípio é que não podemos desistir de nenhum deles. Se um aluno está numa turma do 5.º ano e tem um nível de leitura insuficiente, temos que fazer alguma coisa, mas o professor tem a desculpa de que tem de “dar o programa” para os que o conseguem abordar. A nossa ideologia educativa é cheia de palavras de ordem como “individualização da aprendizagem”, “respeito pelos diferentes ritmos de aprendizagem”, mas será que têm alguma efetividade? Haverá, com certeza, escolas onde será esse o caso. Que nos digam, então, como fazem para aprendermos todos uns com os outros.

E os NEE? “Disadvantaged students get extra help but are pushed to succeed on the same terms as everyone else, for that is what the adult job market will demand.”. Pois os testes de avaliação servem para dizer o que um aluno sabe e é capaz de fazer. Assim como as notas. Sou contra os “chumbos”, mas defendo a verdade das notas. Com base nesses números, se forem verdadeiros, podemos tomar decisões sobre como cada aluno deve prosseguir sem deixar aprendizagens essenciais para trás.

Do outro lado: verifica-se que a Universidade da Califórnia se queixa de que muitos dos seus calouros não dominam competências matemáticas equivalentes (estou equiparando) às do 9.º ano escolaridade, mas chegam com classificações da ordem GPA 4.0 (Grade Point Average) que equivalem a 5 e a 18-20 nas nossas escalas.

Isto tem a ver com a tal manipulação das desculpas referidas acima: “Colleges have accepted dubious claims of disability so that students can, for example, get extra time for tests. The Atlantic reports that 38 percent of Stanford undergraduates are registered as having a disability.”

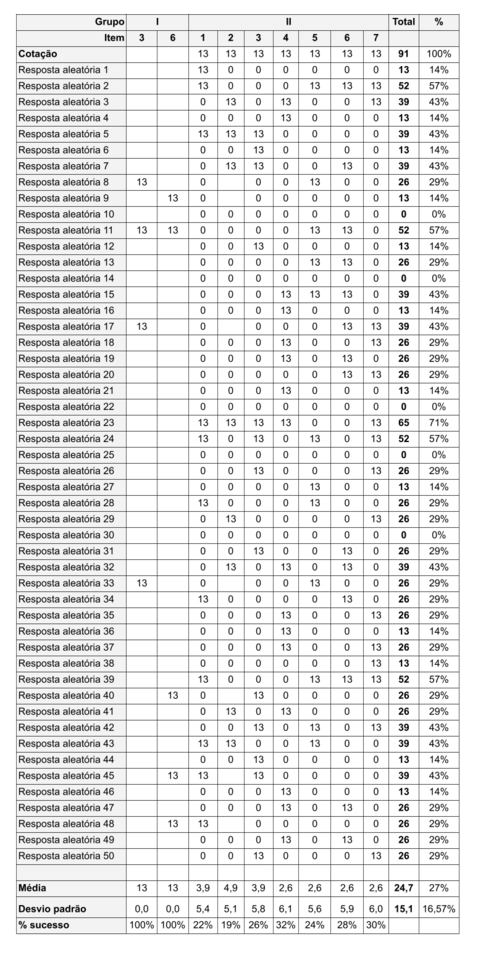

A verdade e a autenticidade das classificações são um problema de informação; se não distinguem nada, não servem para nada. Para os alunos mais fracos, notas desajustadas são um presente envenenado, que deixam de valer no mercado das apreciações precisamente por lhes terem sido atribuídas. É ao fim e ao cabo uma coisa muito fiduciária.